Cette période est caractérisée par la convergence de plusieurs technologies clés : l'essor des appareils mobiles, le développement du cloud computing, l'explosion des données (Big Data) et l'avènement de l'Internet des objets (IoT). Ces éléments ont profondément transformé notre façon de vivre, de travailler et d'interagir avec le monde.

L'essor des smartphones et des tablettes :

L'arrivée des smartphones

Bien que les premiers téléphones intelligents existent depuis les années 1990, c'est l'arrivée de l'iPhone d'Apple en 2007 qui a véritablement révolutionné le marché. L'iPhone, avec son interface tactile intuitive, son App Store et son accès facile à Internet, a popularisé le concept du smartphone auprès du grand public. L'émergence d'Android, le système d'exploitation mobile de Google, a ensuite contribué à une adoption massive des smartphones à travers le monde. Les smartphones sont devenus de véritables ordinateurs de poche, offrant une multitude de fonctionnalités : navigation web, messagerie, applications mobiles, photographie, vidéo, GPS, etc.

L'essor des tablettes

Les tablettes tactiles, popularisées par l'iPad d'Apple en 2010, ont offert une nouvelle façon d'interagir avec les contenus numériques, grâce à leur grand écran tactile et à leur portabilité. Elles sont devenues des outils populaires pour la consommation de médias, la lecture, les jeux et certaines tâches professionnelles.

Le développement du cloud computing et des services en ligne

Le cloud computing

Le cloud computing consiste à stocker et à accéder à des données et des applications via Internet, plutôt que sur un ordinateur local ou un serveur physique. Cette approche offre de nombreux avantages : accessibilité depuis n'importe quel appareil connecté, scalabilité (possibilité d'adapter les ressources informatiques aux besoins), réduction des coûts d'infrastructure, maintenance simplifiée, etc. On distingue différents modèles de cloud computing :

IaaS (Infrastructure as a Service) : Fourniture d'infrastructures informatiques virtualisées (serveurs, stockage, réseaux). Exemples : Amazon Web Services (AWS), Microsoft Azure, Google Cloud Platform.

PaaS (Platform as a Service) : Fourniture d'une plateforme de développement et de déploiement d'applications. Exemples : Google App Engine, Heroku.

SaaS (Software as a Service) : Fourniture d'applications logicielles accessibles en ligne. Exemples : Salesforce, Microsoft Office 365, Google Workspace.

Les services en ligne

L'essor du cloud computing a favorisé le développement d'une multitude de services en ligne, tels que :

Les réseaux sociaux : Facebook, Twitter, Instagram, etc., qui permettent aux gens de se connecter, de partager du contenu et de communiquer.

Les plateformes de streaming : Netflix, Spotify, YouTube, etc., qui offrent un accès à la demande à des films, des séries, de la musique et des vidéos.

Les services de stockage en ligne : Dropbox, Google Drive, iCloud, etc., qui permettent de stocker et de synchroniser des fichiers dans le cloud.

L'intelligence artificielle (IA)

L'IA vise à créer des machines capables de simuler l'intelligence humaine, en réalisant des tâches telles que la reconnaissance vocale, la vision par ordinateur, la traduction automatique, la prise de décision, etc. Les avancées récentes en apprentissage automatique (machine learning) et en apprentissage profond (deep learning), grâce à la puissance de calcul augmentée et à la disponibilité de grandes quantités de données, ont permis des progrès considérables dans le domaine de l'IA.

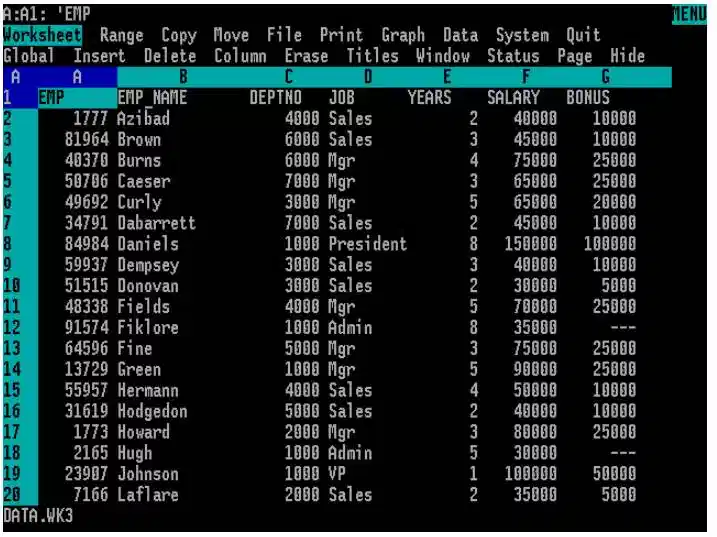

Le Big Data

Le Big Data désigne les ensembles de données massifs et complexes qui ne peuvent pas être traités par les outils traditionnels de gestion de données. L'analyse du Big Data permet d'extraire des informations précieuses et de prendre des décisions éclairées dans de nombreux domaines : marketing, finance, santé, recherche scientifique, etc.

L'Internet des objets (IoT)

L'IoT désigne l'interconnexion d'objets physiques à Internet, permettant la collecte et l'échange de données. Les objets connectés (montres intelligentes, thermostats connectés, appareils électroménagers intelligents, etc.) collectent des données sur leur environnement et sur leur utilisation, ce qui permet d'améliorer leur fonctionnement, d'automatiser des tâches et de créer de nouveaux services.

Cette période est donc marquée par une transformation numérique profonde, avec l'omniprésence des appareils mobiles, le développement du cloud computing, l'explosion des données et l'avènement de l'Internet des objets. Ces technologies continuent d'évoluer rapidement et de façonner notre monde.

.webp)